使用高斯过程进行情感识别的动态面部标记选择

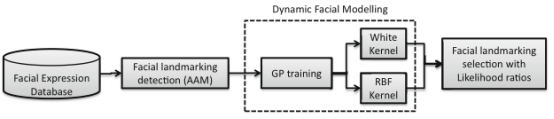

摘要:面部特征是情感识别过程的基础,并广泛用于情感计算系统。这种情绪过程是由生理信号的动态变化和与面部表情有关的视觉答案产生的。在这个过程中一个重要的因素,依赖于面部表情的形状信息,表示为动态改变面部标志。在本文中,我们提出了一个基于动态面部界标选择的框架关于使用高斯过程的面部表情分析。我们基于活动外观模型进行面部特征检测,然后对动态情绪序列使用高斯过程排序,以确定哪些标志与情绪多变量时间序列识别更相关。实验结果表明,高斯过程可以有效地适应情绪时间序列,并且具有对数似然的排序过程找到代表给定面部表情序列的最佳标志(嘴和眉毛区域)。最后,我们使用情感识别任务中排名最好的标志,获得情绪数据集的动作和自发情景的精确表演。

关键词:面部标志、动态情绪、统计模型、高斯过程、高斯过程排序

1. 介绍

面部标志分析在许多面部处理操作中的应用中起着重要的作用,包括情绪识别,面部动画和生物识别[5]。分析这些信息在情绪识别领域特别有用,因为从标志分析(例如眼角,眉毛,嘴角等)我们可以描述给定的面部表情。由于面部表情的特征是面部肌肉的变化,我们需要捕捉面部特征的动态变化。此外,这些时间面部变化主要由从面部标志导出的面部形状信息表示[12]。

尽管在现有技术中已经广泛研究了用于定位面部标志的面部特征检测方法,但是对于从面部标志分析得出的情感识别系统而言,计算机视觉问题已经证明是非常具有挑战性的[32]。为了确定哪些面部特征与识别情感类型更相关,大多数情感识别工作都是基于Ekman的研究[9]。本研究提出了一种全面的,基于解剖学的系统称为面部动作编码系统(FACS),该系统用于测量所有视觉上可辨别的面部动作,称为动作单位(AUs)。由于AU与解释无关,因此可用于任何高层决策过程,包括根据情绪FACS(EMFACS)识别基本情绪,根据FACS影响解读数据库(FACSAID)识别各种情感状态 )[10],并承认其他复杂的心理状态,如抑郁或疼痛[9]。

由于AU适用于面部表情的研究(因为成千上万的解剖学上可能的面部表情可以被描述为27个基本AU和许多AU描述符的组合[11]),所以越来越多的研究并不令人惊讶 对人类自发的面部行为是基于AU自动识别的[6,33]。此外,面部标志被用来计算这些AU以执行面部表情分析[7,39]。用于执行面部表情分析的典型的面部特征是形态学特征,例如面部区域(眼睛,鼻子,面部轮廓,嘴巴等)的形状,以及面部突出点的位置(眉毛的角落 ,嘴巴,下巴尖等)[28]。 然而,这些方法并没有解决哪些点在面部表情序列的分析中最相关。

Pantic和Valstar报道了面部动作单元识别及其时间片段的不同研究[35]。

在他们的所有研究中,只有一组特定的面部标志(眉毛,眼角,嘴角和鼻尖)用于计算动作单位[26]。由于每个主题的面部表情都不同,由于每个人表现特定情绪的特征,提出一种方法来研究各种各样的面点及其时间动态变化很重要,以便识别更大范围的表情(除了原型的,即自发的面部表情)[14]。此外,情感识别领域的大部分作品都基于使用整个脸部形状模型(或使用一些突出点,如鼻尖,眼角,嘴角和眉毛)[34]。由于自发的情绪行为取决于人们如何看待自己的环境[31],因此需要分析哪些特定的面部标志以情感顺序带来更多相关信息。本文的主要研究课题是模拟每个面部标志的时间活动,并对描述情绪过程的面部特征进行排序[14]。

此外,值得一提的是,在现代艺术中有许多作品,其中动态分析被用于情感识别[42]。在这里,大多数这些作品使用生理信号,如脑电图,肌电图,呼吸和心率来进行识别[25,29,38]。但是,使用面部表情功能进行动力分析的作品是基于此的仅在计算行动单位作为功能,但丢弃了建模面部标志的时间变化[29]。

由于需要在情绪序列中对面部特征的动态进行建模,因此我们使用监督学习来进行回归任务。通常参数模型已被用于此目的。这些方法具有易于解释的潜在优点,但对于复杂的数据集,简单的参数化模型可能缺乏广义性能。高斯过程(GP)[22,30]提供了一种强大的方法来实现量化面部表情时间序列中嵌入的动态面部特征,从而允许我们对最能描绘动态面部的面部特征组进行排序表达。

在一个动态的面部表情框架中,与回归任务中使用的平方指数协方差函数或径向基函数相结合的高斯过程可以高效地在情绪时间序列中执行动态的面部特征选择[31]。这个属性使GP在捕捉面部特征的动态标志变化方面具有广泛的灵活性。 此外,这个属性使得GP成为情感计算应用的一个有吸引力的新颖工具[18]。

在这项工作中,我们通过使用高斯过程分析面部表情的动态视觉答案(特别是FACS [27]中的区域)的动态视觉答案,开发了一种用于面部界标选择的新技术。这些功能通过使用统计模型作为活动外观模型进行检测,(AAM)在[23]中提出,它根据先前的目标知识(要分析的面),使我们能够高精度地估计目标形状。从检测到的面部特征中,可以估计哪些标志在特定的动态面部表情中更相关。所提出的方法采用高斯过程对动态面部特征进行回归,目的是确定哪些标志在动态情绪过程中更相关。面部特征根据信噪比(SNR)进行排序,信噪比通过拟合高斯过程来捕获。另外,对多个数据集进行统计分析以验证所提出的方法的普遍性。最后,我们针对每个情感时间序列使用最佳排名的面部标志,然后执行基于隐马尔可夫模型(HMM)的动态分类任务用于验证目的。这项工作的主要贡献是开发一种方法,该方法能够在涉及情绪识别时对与动态情绪序列更相关的面部标志进行排序。

该文件包括以下部分。2.2节介绍了这项工作中使用的面部特征提取模型。第2.3节介绍了我们的面部标志选择方法。2.4节和3节分别讨论实验设置和结果。该论文在Sect.4,对未来的研究进行总结和讨论。

2.材料和方法

2.1数据库

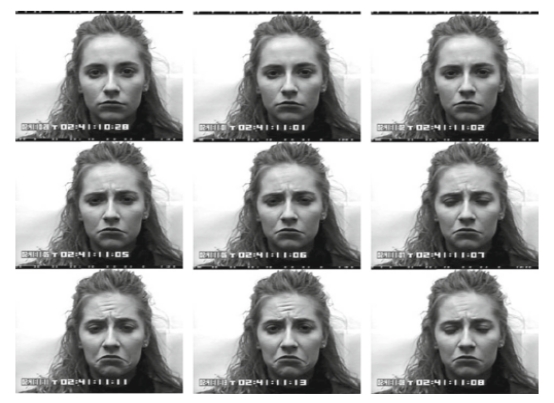

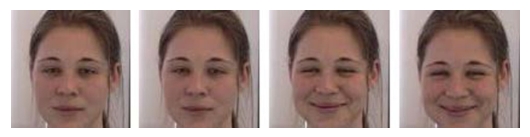

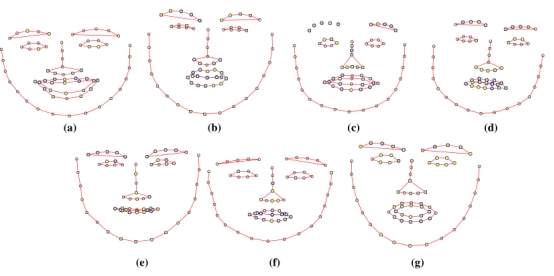

在这项工作中使用了四个数据库(参见表1的说明)。 第一个数据库是Cohn-Kanade AU编码的人脸表情数据库。它被开发用于自动面部图像分析和合成的研究知觉研究[21]。它包括有姿势和无姿势(自发)表情以及其他类型的元数据(带有图像,面部标志,动作单元和情感标签的文件)。每个序列的目标表达式都完全由FACS编码。此外,已验证的情感标签已添加到元数据中。 因此,可以对动作单元和原型情绪进行序列分析[9](见图1)。 第二个数据库是来自慕尼黑技术大学的带有面部表情和情绪的FEED数据库,其中包含显示许多头像的脸部图像受试者执行Eckman和Friesen定义的六种不同的基本情绪[36](见图2)。 该数据库已经作为欧盟项目FGNET(人脸和手势识别研究网络)的一部分生成。该数据库包含从18个不同个人收集的材料,每个人都执行了所有六个期望的动作三次。另外记录了三个完全没有表达的序列。总而言之,这给出了399个序列的数量。 第三个数据库是OuluCASIA面部表情数据库[40]。这个数据库是由奥卢大学机器视觉小组开发的,该小组由来自80至23岁至58岁之间的六个典型表情(惊喜,快乐,悲伤,愤怒,恐惧和厌恶)组成。要求受试者根据给定序列中所示的表达实例(活动的面部表情)进行面部表情(参见图3)。

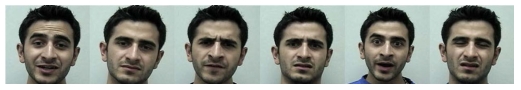

最后,第四个数据库是RMLemotion数据库,我们使用了Ryerson大学Ryerson多媒体实验室收集的60个(每个情绪十个)自发视听情绪表达样本(见图4)。表达了六种基本的人类情感:愤怒,厌恶,恐惧,幸福,悲伤,惊奇。RML情绪数据库适用于基于音频,基于静态图像以及基于视频的二维和三维动态分析和识别[37]。

|

名称

|

序列号

|

表情/姿势改变/照明

|

彩色/灰度

|

解析度

|

主题数量

|

年

|

|

Cohn-Kanade数据库

|

327

|

7,No,No

|

灰度

|

640*490

|

123

|

2003

|

|

FEED数据库

|

399

|

7,No,Yes

|

彩色

|

320*240

|

18

|

2006

|

|

Oulu-CASIA数据库[40]

|

480

|

6,No,Yes

|

彩色

|

320*240

|

80

|

2011

|

|

RML情绪数据库

|

200

|

6,Yes,Yes

|

彩色

|

640*480

|

7

|

2008

|

表1本工作中使用的面部表情数据库

图1 Cohn Kanade数据库的情绪表达描述,可以看到情绪过程(起作用)从中性到高峰表达(右下)

图2 FEED数据库的情绪序列描述,可以看到情绪过程从中性到高峰表达

图3 Oulu-CASIA面部表情数据库的情绪序列的描述,其中在弱照明场景中记录情绪过程(已起作用)

图4显示自发情绪序列的RML情绪数据库的示例图像

2.2 用于面部特征提取的活动外观模型

活动外观模型(AAM)是通过学习一类对象的标记特征的过程而构建的。 AAM允许我们找到这样一个模型的参数,该模型生成的合成图像尽可能接近特定的目标图像,假设一个合理的初始近似[23]。

2.2.1标记训练集

为了构建我们的面部特征提取方法(AAM),我们选择面部图像并入训练集这里,一个重要的任务是确定哪些面部图像将被包括在训练集中。为此,必须考虑面部表情的期望变化(即原型面部表情和包括特定面部姿势的面部表情)。因此,我们将Ekman的研究所定义的面部表情标记为基本情绪(即快乐,愤怒,恐惧,厌恶,悲伤,蔑视和惊讶)[9]。然而,由于需要建模自发的情绪行为,我们记录着与RML数据库相关的面部表情。在这里,为了在识别过程中添加这些自发的面部表情,标记了十个对象。为了构建AAM模型,我们使用了来自CK数据库的50个情感序列,来自FEEDTUM的50个序列和来自RML数据库的50个序列。从这些序列中,我们模拟所有与原型情绪和自发情绪(即给定的面部表情)有关的形状变化。此外,我们添加了50个Oulu-CASIA数据库序列,以模拟更复杂的场景(即弱照明)。

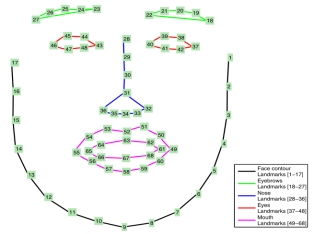

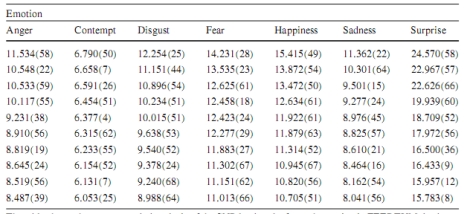

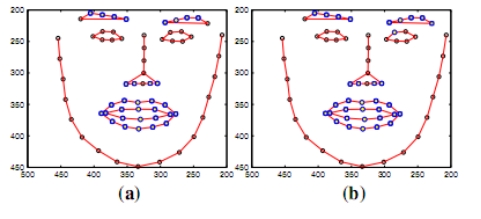

我们使用用于CK数据库的参数化人脸模型[21]。 在这里,为了描述面部形状(用于描述眼睛,鼻子,嘴和眉毛区域的标志),为数据集中的每个图像标记了一组68个标志。 图5显示了用于描述面部表情的形状模型的一个例子。

图5 CK数据库的面部描述,使用一组68个标志来描述形状模型

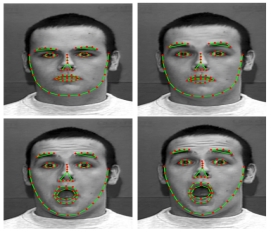

2.2.2面部标志检测

AAM包含感兴趣对象的形状和灰度外观的统计模型,其可以推广到几乎任何有效的示例(标记的面部表情)。匹配到图像涉及找到模型参数(形状和外观描述符),将其投影到图像中的图像,并得到合成模型示例之间的差异。可能大量的参数使得这成为一个难题。我们使用Matthews和Baker [23]提出的面部标志检测方法。将AAM算法应用于建立形状和外观模型。然后,通过将构建的模型拟合到面部序列来执行面部界标检测。 我们使用使用C++中的OPENCV的Active Appearance Model Face Tracker库来执行面部追踪。 图6显示了关于每个情感原型的标志如何位于形状模型中的示例。

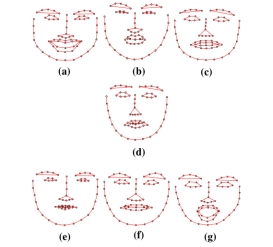

图6 每种情绪的面部表情样本a.快乐 b.厌恶 c.恐惧 d.悲伤e.愤怒 f.蔑视

g.惊喜

为了对标志检测过程进行误差分析,我们计算了所有训练和测试图像中手动标记的点

与由模型

与由模型

估计的点之间的距离的平均误差。此外,为了对AAM调整的准确性进行定量分析,我们计算了手动标记的面部标志点与AAM模型为眼睑和口腔区域估计的点之间的相对误差。

估计的点之间的距离的平均误差。此外,为了对AAM调整的准确性进行定量分析,我们计算了手动标记的面部标志点与AAM模型为眼睑和口腔区域估计的点之间的相对误差。

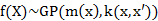

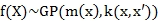

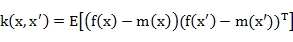

2.3高斯过程

高斯过程(GP)由输入空间索引的标量随机变量的无限集合组合而成,使得对于任何有限输入集合

,随机根据多元高斯分布

,随机根据多元高斯分布

[24]来分布变量。一个GP完全由平均函数m(x)= E [f(X)](通常定义为零函数)和一个协方差函数指定。

[24]来分布变量。一个GP完全由平均函数m(x)= E [f(X)](通常定义为零函数)和一个协方差函数指定。

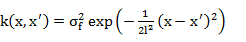

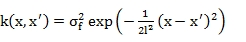

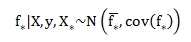

协方差公式:

(1)

(1)

我们使用方程式(1)给出的平方指数内核(径向基函数(RBF)kernel),其中

是控制函数的方差,

是控制函数的方差,

是指定任何两个输入

是指定任何两个输入

变得不相关的距离的长度比例。此外,如果有n个输入,我们可以写出方程 (1)以矩阵形式表示,其中

变得不相关的距离的长度比例。此外,如果有n个输入,我们可以写出方程 (1)以矩阵形式表示,其中

表示在所有输入对处评估的协方差的n×n矩阵。

表示在所有输入对处评估的协方差的n×n矩阵。

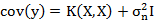

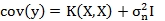

此外,通过使用噪声观测值的预测,观测值由

给出,噪声观测值上的先验值变为:

给出,噪声观测值上的先验值变为:

(2)

(2)

其中

表示协方差矩阵。

表示协方差矩阵。

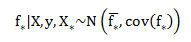

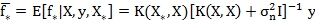

通过使用多元高斯性质,可以获得新输入

的预测分布

的预测分布

[4]。高斯过程回归由下列公式给出:

[4]。高斯过程回归由下列公式给出:

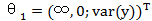

为了估计核心参数,我们最大化的边际可能性要比在离散的数值网格上使用穷举搜索更快,而验证损失是一个目标[2,24]。 在这里,边际可能性是指边际化函数值

[4]。

[4]。

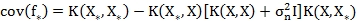

由于高斯过程的先验值是高斯的真实值,

,而且可能可以分解为

,而且可能可以分解为

, 对数边际可能性由下式给出

, 对数边际可能性由下式给出

(4)

(4)

从方程 (4)中,我们可以通过优化GP的对数 - 边际似然函数来从数据中计算超参数

[4]。

[4]。

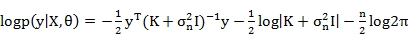

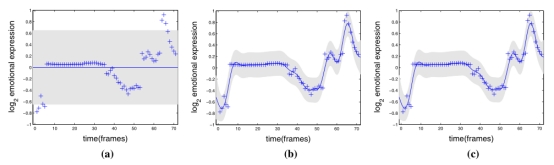

图11 CK数据库中情绪表达的高斯过程回归。

该图显示,GP适合情感表达样本,具有不同的长度超参数

(对于与眉毛区域相关的标志)的设置。蓝色十字表示时间(面部形状变化之间的

(对于与眉毛区域相关的标志)的设置。蓝色十字表示时间(面部形状变化之间的

比率)的零均值面部表情序列(对于样品界标),并且阴影区域表示点对平均值加/减两倍标准偏差(95%置信区域)。 a-c显示l 2的不同设置,

比率)的零均值面部表情序列(对于样品界标),并且阴影区域表示点对平均值加/减两倍标准偏差(95%置信区域)。 a-c显示l 2的不同设置,

,

,

分别为8.9443和5.4772。

分别为8.9443和5.4772。

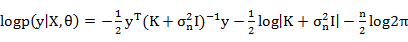

2.3.1用可能性比率排序

在本文中,我们使用[15]中介绍的方法,通过高斯过程(GP)回归来估计基因表达时间序列的连续轨迹。 在本文,每个配置文件的差异表达通过边际可能性的对数比率排序。这种方法也被[1]用应于从运动捕捉数据集中选择有意义的输出。为此,我们使用对数似然比的对数(LML)3来计算贝叶斯因子,这个因子由下式给出:

(5)

(5)

其中每个LML是θ的不同实例的函数。

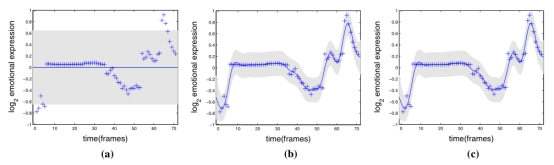

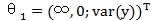

为了得到排序与似然比,我们首先设定两个不同的假设4 [15]。首先,

表示面部表情时间序列(针对每个界标)如何具有显着的基础信号(即,表示情绪序列中的相关改变的面部界标)。其次,

表示面部表情时间序列(针对每个界标)如何具有显着的基础信号(即,表示情绪序列中的相关改变的面部界标)。其次,

表示在面部表情中没有潜在信号的事实,并且针对给定情绪的观察面部序列仅仅是随机噪声的效应。

表示在面部表情中没有潜在信号的事实,并且针对给定情绪的观察面部序列仅仅是随机噪声的效应。

根据这些假设,我们将

与超参数

与超参数

以在时间

以在时间

下,没有基础信号

下,没有基础信号

情况下对函数常数建模。这个过程产生一个面部界标时间序列,其方差可以完全由GP中的噪声(

情况下对函数常数建模。这个过程产生一个面部界标时间序列,其方差可以完全由GP中的噪声(

白色内核解释)。最后在

白色内核解释)。最后在

上,设置超参数

上,设置超参数

以模拟适合情绪过程的面部标志序列。在这里,我们使用独特的信号方差来解释观察到的面部序列方差(

以模拟适合情绪过程的面部标志序列。在这里,我们使用独特的信号方差来解释观察到的面部序列方差(

)和无噪音

)和无噪音

。

。

2.4 步骤

在估计属于情绪序列的面部标志之后,我们继续训练高斯过程来动态地测量这些标志在给定情绪序列中哪个更具相关性。我们使用GPmat工具箱进行[15]中开发的高斯过程排序。以下步骤描述了使用高斯过程对面部界标选择提出的方法。

1.对于情感序列中的每个标志。

(a)按照2.3.1第二部分描述的两个假设对GP进行培训。

(b)计算边际可能性的对数比[见方程(5)]。这里,面部标志等级是基于

与

与

相比有多大可能性,根据信噪比

相比有多大可能性,根据信噪比

给出脸部表情序列。

给出脸部表情序列。

2.对所有动态情绪表达式中的每个标志进行类似日志的比率排序。

图7动态面部标志选择过程

图8用于定义形状模型的标志。 该图显示了与每个人脸区域相关的一组标志

图7显示了面部界标选择过程的方案。此外,图8显示了与形状模型的每个标志相关的标签。该图描绘了表示形状模型的所有标志的标签。标签1-17对应于面部轮廓; 标签18-27对应于眉毛区域; 标签28-36对应于鼻子区域; 标签37-48对应于眼睛,标签49-68对应于嘴巴区域

3 结论

3.1外观模型估计误差

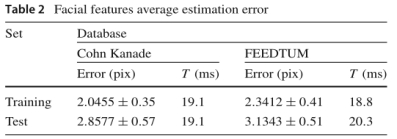

表2显示了面部标志检测精度。我们计算两个数据库(CK和FEEDTUM)的手动标志与AAM模型估计的面部标志点之间的均方差的平均值。此外,计算标准偏差以及面部标志检测过程的时间平均值。

表2人脸特征平均估计误差

该表显示了面部特征的强健适合性,并证明适用于在线应用

在表2中可以看出,虽然CK数据库中训练集图像的面部标志检测精度较高,但测试图像的平均误差也较小。 这是由于训练AAM模型的过程非常严格,在这个过程中,我们考虑了所有原型情绪下的面部表情(情绪过程从中性表达到apex)。 此外,值得注意的是,虽然FEED数据库的图像平均误差比CK数据库的平均误差略高,但估计模型的精度仍然较高,并且满足面部标志物检测任务。 另外,注意到估计模型的平均时间(T [ms])相对较小,这有助于在线应用。

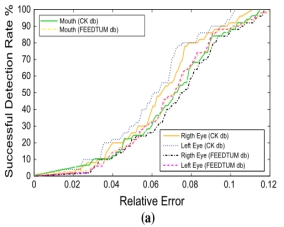

3.2相对误差的分布

为了测量面部标志物与给定表达的匹配程度,我们分别计算了人工标记的标志和由AAM模型估计的着陆点之间的相对误差。 为此,我们计算每个区域的一组标志(手动标志和估计的标志之间的距离)的欧式距离。 然后,我们对数据集中所有图像的所有这些距离进行排名。 我们遵循成功检测率的标准,其中给定的估计轮廓对应于合理的区域(分别为嘴巴和眼睛)[13]。 这个标准表明,如果相对误差Rerr = 0.25(当欧几里德距离的成功检测率达到100%时),AAM模型与人脸的匹配被认为是成功的。

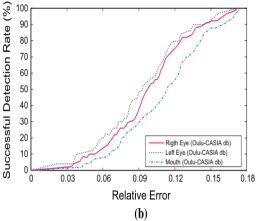

图9示出了相对于成功检测率的相对误差的分布函数,据此观察到,在右眼匹配的情况下,相对误差为0.1,左眼为0.098,在CKDB中为0.12 图像,检测率为100%,表明AAM模型在匹配过程中的准确性较高。 相对误差显示在面部图像中估计面部特征的准确性。 此外,可以看出,由于较小的相对误差值(小于0.12),形状模型稳健地拟合,确保了面部标志的正确位置。

a正常室内照射场景 b弱照明场景

图9 CK,FEEDTUM和OuluCASIA数据库相对误差与成功检测率的关系。

此外,在图9中,可以看到FEEDTUM db的相对误差达到检测率的100%,相对误差如眼睛分别为0.118和0.119,嘴部分别为0.12; 这些误差远低于0.25的既定标准。

为了在更复杂的场景中测试我们的训练模型,我们使用Oulu-CASIA数据集对给定面部图像中的面部表情进行建模。 图9显示,当场景照度较弱时(Oulu-CASIA db),外观模型达到检测率的100%,眼睛和嘴部区域的相对误差在0.165-0.18之间; 与0.25的准则相比,这给我们一个可接受的误差(弱照度)。此外,结果表明,即使在照明场景较弱的情况下,训练模型也可以准确地精确给定一个给定的面部表情。

此外,其他一些作品认为Rerr <0.25的标准不适用于分辨率较低的图像中的面部特征检测。 这里,为了执行成功的检测,考虑Rerr <0.15的相对误差[13]。 基于这个假设,我们证明了在这项工作中使用的AAM模型是有效的并且满足了这个要求。

3.3面部标志选择

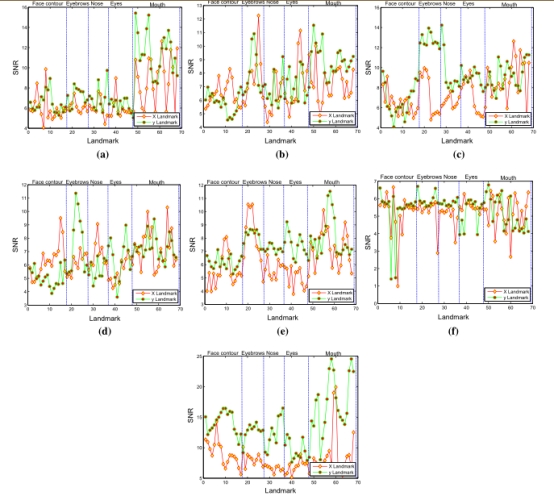

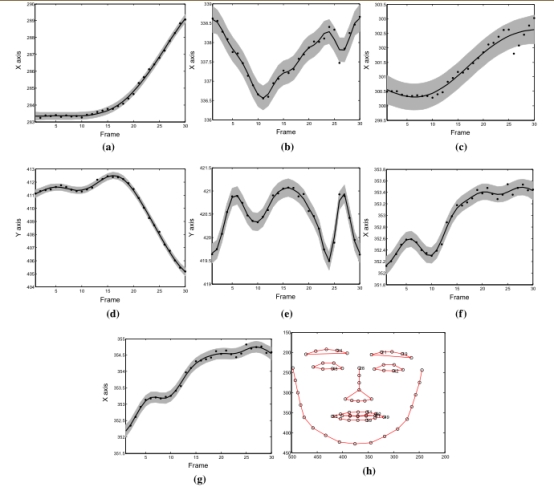

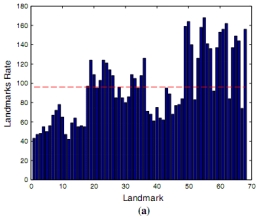

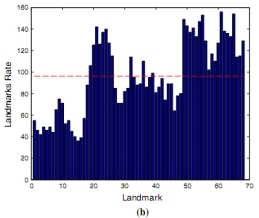

在本节中,我们使用上面提到的面部标志选择方法提出实验结果(参见2.4节)。 图10显示了两个数据库的信噪比(SNR)结果,并显示哪些面部标志在情绪序列中更相关。 结果表明存在具有高信噪比的标志,并且可以在情感识别任务中更相关。 为了对判别性标志进行定量测量,我们使用表示情绪序列的最佳标志进行GP回归。 图12显示了适合每种情绪序列的回归过程。 这个过程导致代表所有情绪的最佳标志。另外,图12显示了位于形状模型中的这些界标。 该图显示了一个情感时间序列样本的GP回归,其中可以看出,GP能够更好地拟合那些与情绪序列更相关的标志。

图10从所有情绪序列中的每个界标获得平均SNR(每个情感的SNR界标值)。在这里,我们将白色GP方差方面与RBF方差(径向基函数)进行比较,以分别评估x轴和y轴情感时间序列中每个标志的可变性。用蓝色虚线分隔的段代表每个脸部区域(脸部轮廓,眉毛,鼻子,眼睛和嘴巴)的一组标志。 a幸福,b厌恶,c恐惧,d悲伤,e愤怒,f蔑视,g惊喜

图11 CK数据库中情绪表达的高斯过程回归。

为了在回归过程中执行定量分析,我们计算长度比例参数

对GP的影响。 图11显示了一个小长度尺度意味着f沿着时间快速变化,并且一个大的长度尺度意味着f几乎表现为一个常数函数。 此外,通过使用RBF内核,我们可以证明,当结合超参数自适应时,回归过程变得非常强大(参见2.3节)(图12)。

对GP的影响。 图11显示了一个小长度尺度意味着f沿着时间快速变化,并且一个大的长度尺度意味着f几乎表现为一个常数函数。 此外,通过使用RBF内核,我们可以证明,当结合超参数自适应时,回归过程变得非常强大(参见2.3节)(图12)。

图12所有情绪的GP回归。 结果显示每个情绪的相关标志(包括SNR)。

a.标志19,SNR = 30.2049(愤怒) b. 标志 61,SNR = 12.9775(蔑视)c.标志42,SNR = 13.0877(令人厌恶) d.标志24,SNR = 27.0208(恐惧)

e.标志55,SNR = 16.6506(幸福) f.Landmark 51,SNR = 17.5877(悲伤)

g.标志59,SNR = 20.7552(意外)。 h具有最佳SNR标志的形状。

图13每种情绪的判别式标志(黄色点表示最佳排名标志)。 结果表明,位于特定于每种情绪(例如,快乐表情中的嘴唇角落)的那些面部区域中的标志被证明在情感序列中更相关。 a快乐,b厌恶,c恐惧,d悲伤,e愤怒,f蔑视,g惊喜

图13显示了位于所有数据库中每种情绪的形状模型中的最佳SNR界标。我们选择与每个情感的SNR值的平均值相比显示更高SNR值的那些界标的最佳界标。 我们通过计算所有标志的SNR平均值(每个轴的一个阈值)来设置阈值。 这些结果表明,在情绪序列中更具判别力的面部标志位于嘴,眼睛和眉毛面部区域。

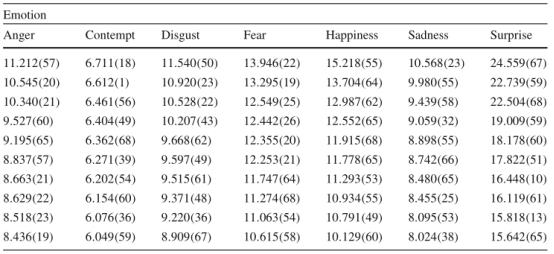

表3 CK数据库每种情感的最佳平均信噪比

该表格显示了对那些被证明与CK数据库的所有情绪序列更相关的标志的更具描述性的分析

表4 FEED数据库每种情感的最佳平均SNR

该表显示了FEEDTUM数据库中每个情绪的SNR标志的相同扩展分析。 结果表明,该数据集的SNR值与CK数据库获得的SNR值密切相关。

总结面部标志性判别过程中得出的结果,表3和表4显示了所用数据库中每种情绪的最佳SNR值。 在两张表中都可以看出,最好的SNR值与眼睛,眉毛和嘴巴区域相对应(见图8查找表格中报告的标签)。 结果还表明,具有高SNR比率的标志可以准确地模拟情绪过程,并有助于影响识别应用。

3.3.1自发情绪

在研究情绪过程被执行的数据库上的情绪序列之后,使用RML情感数据库来执行具有似然比的动态面部界标选择。在这里,自发的情绪序列被用来模拟面部标志动态。结果如图14所示。

图14自发数据库的最佳标志。对自发情绪序列的动态面部分析证明,自发情绪行为显示面部参数与在原型情绪的引发中更敏感的面部区域密切相关。此外,图表显示,在自发情绪序列中呈现出更多相关性的标志,对应于为情感行为数据集(具有高SNR值的标志)而排名的相同标志。 a Loglike,b SNR

图15最佳SNR值的直方图。 为了对最佳排名的标志进行定量评估,我们计算了从回归过程得出的所有SNR值的直方图,从而证明在所有情绪序列中,一些面部标志为动态情绪分析带来重要信息。 水平红色虚线表示给定标志被视为相关的阈值。 以绿色虚线分隔的线段表示每个面部区域的标志集。 由Landmark提供的x Landmark

结果表明,即使对于自发的情绪序列,GP模型也可以对每个具有高SNR值的序列进行匹配。此外,在这个过程中排名的标志与其他标志选择过程中发现的更相关的标志相对应数据库(这意味着自发的情绪过程具有与原型情绪类似的面部表情)。图15显示了数据库中所有主体的最佳SNR界标率。根据所有受试者的SNR值计算直方图(分析标志的x轴和y轴)。我们通过计算所有标志的SNR平均值来设置阈值。此外,从这个阈值我们可以建立一个给定的标志在情感过程中可能被认为是相关的SNR水平。

这个实验的主要目的是对自发情绪过程中所有受试者的SNR值(对于每个界标)进行量化。结果显示位于眉毛,鼻尖和嘴巴区域的标志在自发情绪序列中更相关。

3.4使用面部标志进行情感识别

为了测试我们的面部标志选择方法,我们通过对所选特征执行情绪识别任务来评估每个情绪时间序列的所选标志。为此,我们使用隐马尔科夫模型(HMM)来执行情感识别。观察结果是排序过程中计算的所有选定标志的时间序列。

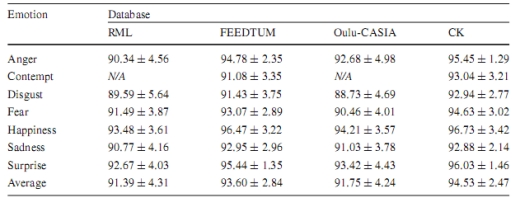

表5使用所选标志用于每种情绪的CK,FEEDTUM,Oulu-CASIA和RML数据库的情感识别准确度。

结果表明,当使用选定的面部标志时,识别性能增加

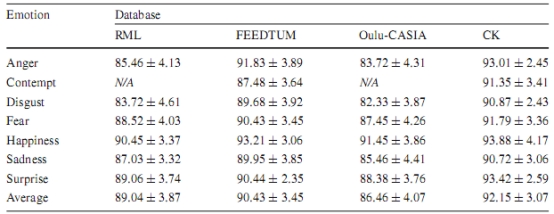

表6使用整套脸部标志设置的CK,FEEDTUM,Oulu-CASIA和RML数据库情绪识别准确性。

结果显示,整个面部标志集对于情绪识别过程而言不太有代表性(低识别率)

表5和表6显示了这项工作中使用的四个数据库(CK,FEEDTUM,Oulu-CASIA和RML)的情绪识别准确性。结果表明,通过使用排序过程中选择的标志,识别准确率增加(CK数据库建议方法为94.53%,FEEDTUM数据库为93.60)。另一个重要结果是,即使使用自发数据库(对于使用RML数据库的所提出的方法,其识别准确率为91.39%),识别准确度也会提高。此外,结果还表明,即使照明场景较弱(Oulu-CASIA数据库的准确率为91.75%),识别率也是准确的。然而,当模型使用整套面部特征进行识别时,识别率大幅下降(见表6)。主要原因在于,当AAM模型在低照度的情况下适合面部形状时,位于面部轮廓(即下巴标志)的标志会导致不准确的识别。此外,这项工作获得的结果表明,我们的方法在情感识别任务中实现了最先进的结果,其中使用了给定的面部特征选择方法(参见[34,41,42])。

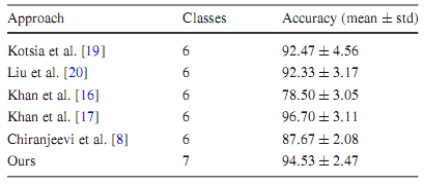

表7所提出的方法与使用CK数据库的情感识别中常用的现有技术方法的实验比较

最后,表7显示了最先进的普通情绪识别方法之间的实验性比较。 该表显示,大多数作品只分析6种原型情绪,因为蔑视情绪具有类似的表达,厌恶和愤怒情绪,使得识别方法不太准确。 然而,Khan等人开发的工作。 [17]表现出比我们的方法稍微好一点的表现(96.7%对94.53%),这可能是由于情绪序列的时间分割(选择覆盖发病到顶点状态的帧)而不是使用整个情绪 时间序列。 此外,实验结果表明,通过对面部表情的时间行为建模,动态特征比静态特征更具代表性(即[8,16,17,19,20]等作品中使用的外观和几何特征)。

4结论和未来的工作

在本文中,我们已经提出了一种用于高斯过程的动态脸部标记选择以及用对数似然比排序的方法。我们已经表明,所提出的方法为最新技术带来了一种分析哪些标志在情感序列中更相关的新颖方式。结果表明,面部界标检测方法是准确的,并符合这类系统的要求。通过定量分析,评估了AAM模型在人脸特征检测中的鲁棒性。结果表明,AAM模型在匹配过程中的误差保持在RMSE的标称值(满足相对误差的标准)。

动态面部标志选择过程中所显示的结果证明,回归任务的监督学习提供了一种可靠的方法来量化情绪序列中的动态面部变化。此外,使用GP对脸部表情时间序列进行建模,使我们能够对情感序列中嵌入的最佳信噪比标志进行排序。我们的方法证明,在情感计算领域开发的作品可以得到改进,因为这些作品中的大部分仅使用属于形状模型的一些面部特征(即,分别为眼角,眉毛和嘴巴)。

此外,结果表明,任何情绪序列都表现出一组可以在给定情绪过程中变化的标志。此外,所提出的方法支持如[31]的工作,其中情绪表征仅包括与情绪识别过程中包含的与形状模型相关的少数几个标志[3,31]。另外,由于在动态面部标记选择过程中的高精度,所提出的方法显示出用于情感识别任务的精确性能。

对于未来的作品,我们计划分析与4D面部表情数据集有关的动态变化,以扩展我们的3D面部形状的框架。此外,如果面部表情描述符(面部痕迹和纹理信息)以情感时间序列呈现相关信息,我们计划研究。最后,我们计划建立一个基于多输出高斯过程回归框架的情感排序过程。

致谢COLCIENCIAS提供资金(Grant No.617-2013)。